决策树ID3算法

决策树(decision tree)是一种基本的分类与回归方法,同时由于自身是弱分类器特别适合集成学习,例如随机森林、XgBoost。

本文将通过ID3算法带大家入门决策树,之后会另写文章谈谈C4.5算法和CART分类回归树。

决策树ID3算法学习目标

- 信息增益

- 决策树ID3算法流程

- 决策树ID3算法优缺点

决策树引入

假设银行需要构造一个征信系统用来发放贷款,如果你是构建该系统的人,你会如何构建该系统呢?

我说说我将如何构建一个银行的征信系统,首先,我会判断征信人的年收入有没有50万,如果有我直接判定他可以贷款,如果没有我会再做其他的判断;其次,判断征信人有没有房产,如果有房产也就是说他有了可以抵押的不动产,既可以判定他可以贷款,如果没有,则不能贷款……

上述整个过程其实就是决策树实现的一个过程,接下来将从理论层面抽象的讲解三种形式的决策树。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5KPug9Zs-1582805130189)(img/决策树ID3算法-决策树判断个人信用贷款.png)]

决策树ID3算法详解

if…else和决策树

如上一节的征信系统构建一样,决策树ID3算法的思想其实很简单,当你在使用$if\ldots{elif}\ldots{else}$敲代码的时候其实就是在使用决策树的思想,但是你有没有想过把哪个判断条件放在$if$上回更好,是先判断年收入还是先判断有没有房产呢?其实在1970年的时候就有一位叫昆兰的大牛使用信息论上熵的概念来思考过这个问题,并在此基础上使用信息增益这个概念构建了决策树决策的过程。

具体的方法是:从根节点开始,计算所有可能特征的信息增益,选择信息增益最大的特征作为根节点的特征,由该特征的不同特征值作为不同的子节点;再对子节点递归调用上述方法,构建决策树;直到所有特征的信息增益都很小或者没有特征可以选择为止,最后得到一颗完整的决策树$T$。

上述方法构建的决策树则会如上图所示类似于算法中的二叉树,但是需要注意的是ID3算法的决策树是多叉树,并且决策树的各个节点使用信息增益选择特征,然后递归构建决策树。

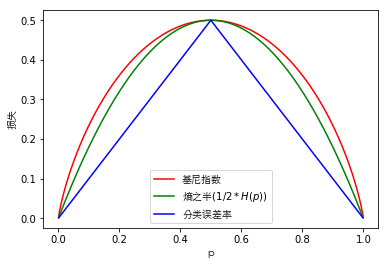

信息增益

熵$H(X)$度量了随机变量$X$的不确定性;条件熵$H(Y|X)$度量了知道$X$以后$Y$剩下的不确定性;$H(X)-H(X|Y)$度量了$Y$在知道$X$之后不确定性的减少程度,这个度量记作$g(Y,X)$,并且在决策树ID3算法中称为信息增益。

从此处可以看出,信息增益越大的特征,$Y$在知道$X$之后不确定性的减少程度会越大,因此更适合用来分类。

决策树ID3算法流程

输入

假设现有一个训练集$D$,特征集$A$,阈值$\epsilon$。

输出

ID3算法决策树。

流程

- 初始化信息增益的阈值$\epsilon$

- 如果$D$中的所有样本都属于同一类$C_k$,则返回单节点树$T$,标记类别为$C_k$

- 如果$A$为空集,则返回单节点树$T$,标记类别为$D$中样本数最大的类$C_k$

- 计算$A$中各个特征对输出$D$的信息增益,选择信息增益最大的$A_g$

- 如果$A_g$小于阈值$\epsilon$,则返回单节点数$T$,标记类别为$D$中样本数最大的类$C_k$

- 如果$A_g$大于阈值$\epsilon$,则按照特征$Ag$的不同取值$A{g_i}$把$D$分割成若干个子集$Di$,每个子集生成一个子节点,子节点对应特征值为$A{g_i}$,递归调用$2-6$步,得到子树$T_i$并返回

决策树ID3算法优缺点

优点

- 理论清晰,方法简单

- 学习能力强

缺点

- 没有考虑到特征连续值的情况,即如人的身高、体重都是连续值,无法在ID3算法中应用,即ID3算法更适合做分类

- 以信息增益作为划分训练数据集的特征,存在于偏向于选择取值较多的特征的问题。因为相同条件下,取值比较多的特征的信息增益大于取值较少的特征

- 没有考虑过拟合问题

- 没有考虑特征中含有缺失值的情况

小结

决策树ID3算法是最原始的决策树算法,由于它较好的解释型在当时也是火了一段时间。但是他的缺点也是特别明显的,树深度大了则容易过拟合,并且无法处理回归问题,无法处理连续值的问题等等一系列问题。

决策树ID3算法由于它自身的缺陷目前已较少使用,也因为这些缺点有了我们下一篇要介绍的算法——决策树C4.5算法。